Programmer's Dilemma

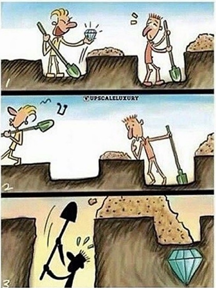

Tamam basligi inglizce attik ama bu sadece bir gonderme * Dilemma, koken olarak nereden gelip nereye gidiyor bilemiyorum ama, sadece 2 seceneginizin olup da hangisini sececeginizi bir turlu bilemediginiz durumlarda kullaniliyor gibi geliyor bana. Reinforcement learningde de karsimiza cikan exploration vs exploitation dilemmasi da buna bir ornek olarak gosterilebilir. Daha fazla space'i explore mu etmek gerek yoksa, var olan bir space'i sonuna kadar somurerek exploit etmek mi? Bizim gibiler icin bu durum su sekilde karsimiza cikabilir: mevcut isyerinde kalip yukselmeye calismak mi (exploitation) yoksa baska (daha sukseli) firmalara girmeye calismak mi (exploration) ? Hadi bunu isyeri olarak dusunup de konuyu gereginden fazla basitlestirmeyelim ama, mevcut durumunu mu korumak vs yeni arayislara mi girmek seklinde yorumlayalim. Meselea bulundugunuz ulkeded kalmak, yerlesmek, entergre olmak (exploitation) vs baska ulkelere (gorunus olarak daha sukseli) mi gitmeye calismak? Uzun